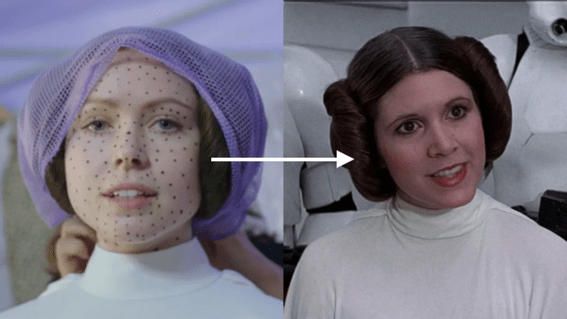

Los deepfakes no son una novedad. Llevamos ya bastante tiempo escuchando hablar de ellos, pero hasta hace muy poco los asociábamos solamente con vídeos virales en los que se suplantaba la identidad de un famoso o bien con los tratamientos de efectos especiales en el mundo del cine, que se erigió como un ámbito pionero en el uso de este tipo de tecnología: uno de los primeros usos exitosos del deepfake se pudo ver en Rogue One: una historia de Star Wars, estrenada en 2016, donde se recreó la cara de Carrie Fisher de joven sobre la actuación de la actriz noruega Ignvild Delia.

Ahora, sin embargo, los deepfakes se han convertido en una herramienta de uso habitual, tanto dentro como fuera del mundo del cine, y accesible para casi todo el mundo. Quizá el caso más sintomático de esta transformación fue el lanzamiento de un spot televisivo que “resucitó” a Lola Flores: con el apoyo de la familia, y una gran agencia de publicidad detrás, consiguieron una réplica virtual espectacular de la cantante.

Casi al mismo tiempo, han empezado a proliferar las aplicaciones de acceso gratuito que permiten crear deepfakes rudimentarios a partir de fotografías y GIFs, ya sea para dar vida a una fotografía antigua de Nietzsche o para poner tu propia cara en un meme famoso. Además, por si esto fuera poco, la tecnología deepfake se ha empezado a utilizar con imágenes donde no salen personas: puedes estar viendo un vídeo en el que algunos de los árboles o edificios en realidad no están ahí.

¿Qué son los deepfakes?

El concepto de deepfake se refiere a aquellas imágenes de vídeo falsas hechas a través de tecnología inteligencia artificial, especialmente a partir de software de “deep learning”. Generalmente se utilizan para suplantar la identidad de una persona, insertando su cara en otro cuerpo, para que se ajuste a la gestualidad facial de la imagen original: los algoritmos inteligentes pueden aprender sobre la marcha, a partir de muchas imágenes de una misma persona, y ajustar por sí mismos la imagen falsa sobre la imagen real hasta conseguir una fusión casi perfecta entre las dos.

Más allá de las consideraciones éticas que pudieran suscitar el hecho que los grandes estudios de Hollywood se plantearan “resucitar” y rejuvenecer a grandes estrellas de cine, la alarma social sobre el peligro que entrañaban este tipo de tecnologías llegó en 2017. La campaña electoral que llevó a Donald Trump a la presidencia hizo que se empezara a hablar de noticias falsas (fake news) de forma generalizada. Y ese mismo año, se viralizó un vídeo de Barack Obama hablando de los peligros de este tipo de noticias, con la particularidad que ese mismo vídeo era a su vez un deepfake: el vídeo fue creado por la Universidad de Washington en colaboración con el director de cine Jordan Peele.

Desde entonces, este tipo de vídeos han seguido apareciendo regularmente, extendiéndose como una amenaza constante. En 2019, se difundía otro hit viral, que no destacaba tanto por su capacidad para pasar desapercibido, sino por su perfección técnica a la hora de generar una imagen evidentemente falsa: Jennifer Lawrence dando un discurso con la cara de Steve Buscemi. En este caso, el deepfake funcionaba como recordatorio de una de las primeras problemáticas asociadas a este tipo de vídeos, pues en esos años se empezó a usar en webs de pornografía para insertar los rostros de actrices famosas en los vídeos sexuales. Algunas víctimas han interpuesto denuncias, se han cerrado webs pornográficas y se ha intentado regular la distribución de este tipo de imágenes, pero es muy difícil frenar este tipo de prácticas.

De hecho, a principios de este año el FBI lanzó un comunicado en el que alertaba sobre el crecimiento desmesurado de vídeos deepfake más allá de los casos de acoso y del uso de las imágenes en material pornográfico; se centraban en los nuevos usos que se les estaba dando en campañas de phishing, es decir, en aquellos casos donde la suplantación de identidad se llevaba a cabo para estafar a personas y obtener sus datos confidenciales.

De los deepfakes a los cheapfakes

A pesar de todo, el uso de imágenes deepfake sigue siendo bastante minoritario. Los deepfakes requieren el uso de una tecnología que es cara, difícil de utilizar y que requiere bastante tiempo. En España, por ejemplo, las principales webs especializadas en combatir las noticias falsas a través del fact-checking no han tenido que desmentir todavía ningún deepfake, pero advierten que el verdadero peligro está en los cheapfakes.

El concepto de cheapfake fue acuñado por Joan Donovan y Britt Paris, expertos en ciberseguridad, para referirse a las técnicas básicas de edición de vídeo que se usan para acelerar, ralentizar, cortar o recontextualizar imágenes veraces con el fin de generar mensajes engañosos o falsos. A diferencia de los deepfakes, estas alteraciones pueden realizarse con cualquier programa de edición de vídeo, y sus efectos para generar bulos pueden ser desastrosos para la comunicación digital, en tanto que universalizan la posibilidad de que un vídeo esté parcialmente falseado.

Asimismo, también empiezan a proliferar otras herramientas para generar imágenes falsas, que no tienen que ver sólo con la suplantación de rostros. La aparición de los deepfakes satelitales es una buena muestra de ello: en las imágenes grabadas vía satélite se pueden inserir edificios, vegetación o geografías que son falsas. En principio, su uso fue pensado para usos militares, pero parece que su uso empieza a extenderse para crear nuevas formas de desinformación digital.

El gran peligro para la comunicación digital

La extensión de la tecnología deepfake en todas sus formas, desde las recreaciones más detallistas hasta las aplicaciones para hacer GIF’s personalizados, pasando por los cheapfakes y los deepfakes satelitales, supone un enorme peligro para la comunicación digital, ya que no se trata simplemente de la posibilidad de crear un sinfín de bulos, sino del hecho que se ponga en duda el valor de toda imagen.

Los deepfakes han sembrado la duda sobre cualquier tipo de información, también sobre la verídica. Hasta ahora, asumíamos por defecto que lo que veíamos en un vídeo era real, y cualquier persona que quisiera negarlo debía aportar pruebas que demostrasen que el vídeo era un montaje o que estaba modificado. Sin embargo, con los deepfakes, esto ya no tiene por qué seguir siendo así: la carga de la prueba ahora recae sobre las propias imágenes.

El caso más exagerado se produjo en Lagos, en Nigeria, en octubre de 2020: tras unas manifestaciones que acabaron con enfrentamientos con la policía, las víctimas de los abusos policiales presentaron ante un tribunal vídeos en los que se podían observar las malas prácticas de los agentes; la policía se defendió diciendo que los vídeos eran manipulados, y las víctimas tuvieron que demostrar no solo los abusos, sino también la veracidad de las imágenes que les servían de prueba.

Por ello, muchos expertos advierten que más que los bulos en sí, el riesgo tiene que ver actualmente con que se extienda la desconfianza hacia toda imagen: que no podamos confiar ya más en lo que vemos, sea un vídeo de una manifestación, una imagen por satélite, la intervención de un presidente o un anuncio de televisión.

Por supuesto, existen muchas formas de detectar los vídeos falsos: en los casos de suplantación de identidad, los expertos proponen que nos fijemos en elementos como el parpadeo o los tonos de la piel; además, se están desarrollando herramientas para discriminar aquellos vídeos que contienen imágenes falsas a través de los metadatos. Pero la capacidad de los deepfakes para hacernos dudar seguirá ahí: la defensa de una comunicación veraz y confiable deberá construirse teniendo esta realidad muy en cuenta.